近日,字节跳动旗下即梦AI平台正式推出新一代AI视频生成模型Seedance 2.0,凭借多模态融合创作、高效生成能力及后期编辑一体化等核心突破,迅速在AI创作圈引发热议,有望进一步降低视频创作门槛,推动短视频、影视广告、动漫等领域的创作变革,成为2026年AIGV行业的重要突破点之一。

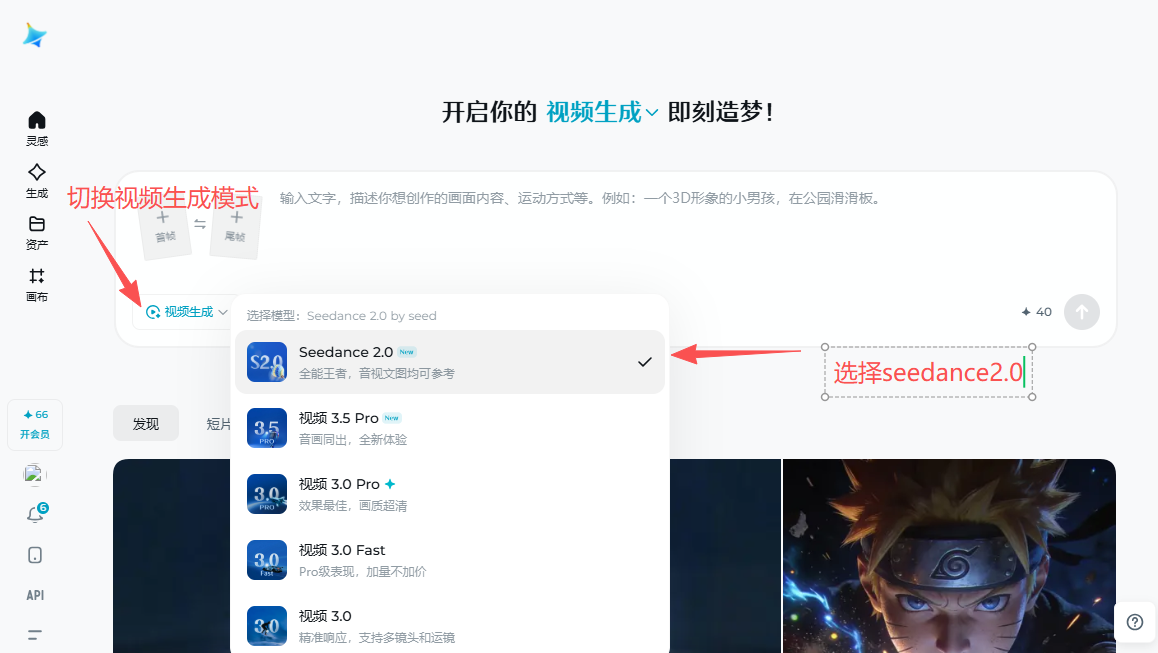

Seedance 2.0在即梦AI中的视频简单使用教学

Seedance 2.0核心定位:多模态驱动,高效可控的AI创作工具

作为字节跳动在AI视频生成领域的升级力作,Seedance 2.0主打多模态参考与高效创作双重核心,区别于传统AI视频模型“生成即定稿”的局限,将AI生成与后期编辑深度融合,用户可直接修改生成内容中的不满意部分,大幅降低废片率,提升创作闭环效率。

该模型目前已在即梦AI平台上线,处于内测灰度阶段,支持桌面端与移动端双端使用,其生成速度实现显著提升,15秒视频约消耗30积分,较上一代模型提速超10倍,兼顾生成效率与内容质量。据悉,其精简版本还同步集成至豆包应用,为普通用户提供免费体验机会,进一步扩大受众覆盖。

核心功能突破:解锁多场景创作新可能

Seedance 2.0在功能上聚焦“精准可控、自然流畅”,针对不同创作场景需求,打造了多项差异化优势,尤其在复杂叙事、动作镜头生成等场景表现突出:

- 多模态参考生成:支持同时上传最多12个参考文件,涵盖图片、视频、音频三种类型,AI可自动学习并复刻参考素材的画面构图、角色特征、动作风格及镜头语言,无需复杂提示词,即可实现对生成效果的精准控制,相当于为创作者提供了“一站式导演工具箱”。

- 原生音视频同步:突破传统AI视频“配音感”痛点,实现人物口型、面部表情与音频节奏的精准对齐,支持对话场景与角色表演,同时内置音频生成能力,可自动生成对话语音、背景音乐及环境音效,实现音画一体化创作,音画错位率控制达到行业优秀水平。

- 多镜头叙事与角色一致性:支持分镜图直接生成视频,在多个镜头切换中,可保持角色面部、服装、表情的高度一致,同时保证灯光连贯性与风格统一,适配预告片、故事片、系列短视频等复杂叙事场景,解决了传统AI视频多镜头创作中角色“变脸”、场景脱节的难题。

- 灵活镜头控制:支持首尾帧精准控制,用户上传第一帧与最后一帧图片后,AI可自动生成中间过渡内容,实现镜头的自然衔接与精准把控,同时具备自动运镜能力,可根据剧情描述自动规划分镜与运镜轨迹,无需用户手动精准指令,即可呈现专业导演级运镜效果。

应用场景广泛:覆盖多行业,赋能全类型创作

依托强大的生成能力,Seedance 2.0已实现多领域落地应用,契合2026年AIGV行业“聚焦高价值场景、实现规模化变现”的发展趋势,具体覆盖以下核心场景:

- 短视频与社交媒体:可快速生成抖音、小红书、TikTok等平台适配的竖屏短视频,支持9:16、16:9、1:1等多种比例,帮助创作者提升内容产出效率,降低创作成本。

- 商业营销与电商:为品牌提供产品宣传视频、活动预告、节日营销内容等创作支持,通过多模态参考保持品牌视觉一致性;同时可制作商品360度展示动画、使用场景演示视频,助力提升电商产品转化率。

- 影视与动漫:可用于动漫片段、影视广告、短剧生成,同时能为电影、电视剧制作分镜预览、场景氛围测试,帮助导演与制片方在前期快速决策,降低影视预可视化成本。

- 教育培训:可制作课程动画、历史场景还原、科学原理演示、语言学习对话视频等内容,通过生动直观的呈现方式,提升教学趣味性与知识理解度。

行业影响:助力AIGV从“生成”向“创作”跨越

随着AI视频生成技术的快速迭代,2026年全球AIGV市场持续升温,国内头部AI视频产品已逐步向“多模态融合、高效可控”靠拢。Seedance 2.0的发布,进一步补齐了AI视频创作“可控性不足、编辑繁琐”的短板,其核心突破体现了AI视频技术向“导演级”控制迈进的行业趋势。

业内人士表示,Seedance 2.0的多模态参考、音画同步及后期编辑一体化能力,不仅能满足专业创作者的高效创作需求,也能让普通用户快速上手,有望推动视频创作从“专业门槛高”向“全民可参与”转变。未来,随着内测的持续推进,其功能将进一步优化,有望在更多行业场景中实现深度落地,为AIGV行业发展注入新动力。

饥荒口袋版

类型:角色扮演

查看